Markdown语法

Markdown语法

Markdown是一种轻量级标记语言,是在2004年由约翰·格鲁伯(John Gruber)创造。 它允许人们使用易读易写的纯文本格式编写文档,然后转换成有效的XHTML/HTML/PDF文档

由于Markdown的轻量化、易读易写特性,并且对于图片,图表、数学式都有支持,许多网站都广泛使用Markdown来撰写帮助文档或是用于论坛上发表消息。甚至包括与博客的编写。成为了程序员甚至大众中比较喜欢的语言之一

Markdown已经成为典型的转换为HTML的非正式规范和参考实现。随着时间的推移,出现了许多Markdown实现。人们开发这些主要是由于在基本语法之上需要额外的功能 - 例如表格,脚注,定义列表和HTML块内的Markdown。其中一些行为偏离了最开始的参考实现。与此同时,非正式规范中的一些含糊不清引起了人们的注意。这些问题促使Markdown解析器的一些开发人员努力实现标准化。

2016年3月发布了RFC 7763和RFC 7764。RFC 7763 从原始变体引入了MIME类型 text/markdown。RFC 7764讨论并注册了MultiMarkdown、GitHub Flavored Markdown (GFM)、Pandoc、CommonMark及Markdown等变体。

Markdown是一种简单的格式化文本的方法,在任何设备上看起来都很棒。它不会做任何花哨的事情,比如改变字体大小、颜色或类型——只是基本的,使用你已经知道的键盘符号。

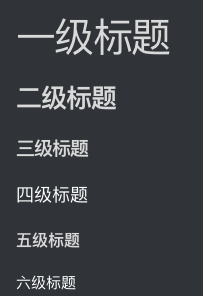

标题

在想要设置为标题的文字前面加#来表示 一个#是一级标题,二个#是二级标题,以此类推。支持六级标题。

示例:

# 一级标题

## 二级标题

### 三级标题

#### 四级标题

##### 五级标题

###### 六级标题

效果如下所示:

当然有些网页的解析方式是不一样的,比如我的博客

字体

加粗 加粗的文字左右分别用两个*号包起来

斜体 倾斜的文字左右分别用一个*号包起来

斜体加粗 倾斜和加粗的文字左右分别用三个*号包起来

删除线 要加删除线的文字左右分别用两个~~号包起来

示例:

**这是加粗的文字**

*这是倾斜的文字*`

***这是斜体加粗的文字***

~~这是加删除线的文字~~

效果如下所示:

这是加粗的文字

这是倾斜的文字`

这是斜体加粗的文字

这是加删除线的文字

块级元素

引用 在引用的文字前加>即可。引用也可以嵌套,如加两个>>三个>>>

分割线 三个或者三个以上的 - 或者 * 都可以。

无序列表 无序列表用 - + * 任何一种都可以

有序列表 使用数字加点1. 2. 3.

列表嵌套 上一级和下一级之间敲三个空格

示例:

* 引用

> 这是引用文案

>> 这是双层引用文案

* 分割线

---

***

* 无序列表

- 列表1-1

- 列表1-2

+ 列表2-1

+ 列表2-2

* 列表3-1

* 列表3-2

* 有序列表

1. 有序列表1-1

2. 有序列表1-2

3. 有序列表1-3

效果如下所示:

引用

这是引用文案

这是双层引用文案

分割线 --- *

- 无序列表

- 列表1-1

列表1-2

- 列表2-1

列表2-2

- 列表3-1

列表3-2

有序列表

- 有序列表1-1

- 有序列表1-2

- 有序列表1-3

图片

语法如下:

图片alt就是图片标题,可以不填写

示例:

效果如下所示:

科尔维特c8

超链接

[超链接名](超链接地址 "超链接title")

title可以不加

示例:

[ctexthuang_blog](https://ctexthuang.com/)

[百度](http://baidu.com)

效果如下所示:

ctexthuang_blog

百度

表格

语法:

表头|表头|

---|:--:|

内容|内容|

内容|内容|

第二行分割表头和内容。

- 有一个就行,为了对齐,多加了几个

文字默认居左

-两边加:表示文字居中

-右边加:表示文字居右

注:原生的语法两边都要用 | 包起来。此处省略

示例

公司|英文|缩写

--|:--:|--:

百度|baidu|B

阿里巴巴|alibaba|A

腾讯|tencent|T

效果如下所示: 公司|英文|缩写 --|:--:|--: 百度|baidu|B 阿里巴巴|alibaba|A 腾讯|tencent|T

代码

单行代码 代码之间分别用一个反引号包起来

代码块 代码之间分别用三个反引号包起来,两边的反引号单独占一行,且前边的反引号后面可以声明语言

ps:我加入||是为了不被转译,正常使用去掉即可

示例:

* 单行

`echo 'hello world';`

* 代码块

|php|

function fun(){

echo "hello world!";

}

fun();|```|

效果如下显示

`echo 'hello world'`

php

function fun(){

echo "hello world!";

}

fun()

#### 流程图

> 这个功能不是所有的解析器都能用的,所以看情况而定

>

> 加入||同样是为了不被转译,正常使用去掉即可

markdown

|```mermaid|

graph TB heyJude[hey Jude] --> doNot(don't) doNot --> makeItBad[make it bad] doNot --> beAfraid[be afraid] doNot --> letMeDown[let me down] makeItBad --> takeASadSong[take a sad song and make it better] beAfraid --> youWereMade[you were made to go out and get her] letMeDown --> youHaveFound[you have found her, now go and get her] takeASadSong --> rememberTo[remember to] youWereMade --> rememberTo youHaveFound --> rememberTo rememberTo --> letHerInto[let her into your heart] rememberTo --> letHerUnder[let her under your skin] letHerInto --> thenYou[then you] letHerUnder --> thenYou thenYou --> canStart[can start] thenYou --> begin[begin] canStart --> toMakeItBetter[to make it better] begin --> toMakeItBetter toMakeItBetter --> betterbetter[better better better better better waaaaa] betterbetter --> na((na)) na --> na

|```|

效果如下显示

mermaid graph TB heyJude[hey Jude] --> doNot(don't) doNot --> makeItBad[make it bad] doNot --> beAfraid[be afraid] doNot --> letMeDown[let me down] makeItBad --> takeASadSong[take a sad song and make it better] beAfraid --> youWereMade[you were made to go out and get her] letMeDown --> youHaveFound[you have found her, now go and get her] takeASadSong --> rememberTo[remember to] youWereMade --> rememberTo youHaveFound --> rememberTo rememberTo --> letHerInto[let her into your heart] rememberTo --> letHerUnder[let her under your skin] letHerInto --> thenYou[then you] letHerUnder --> thenYou thenYou --> canStart[can start] thenYou --> begin[begin] canStart --> toMakeItBetter[to make it better] begin --> toMakeItBetter toMakeItBetter --> betterbetter[better better better better better waaaaa] betterbetter --> na((na)) na --> na

#### 数学公式

公式之间分别用两个货币符号包起来,两边的货币符号单独占一行

示例:

markdown $$ x^2 $$

效果如下所示:

$$

x^2

$$

$$

\prod_{n=1}^{99}{x_n}

$$

$$

\frac{1}{2}

$$

$$

\sqrt{2}

$$

$$

\lim_{n\rightarrow+\infty}

$$

$$

\sum_{i=0}^N\int_{a}^{b}g(t,i)\text{d}t

$$